Einführung KI

Fachbegriffe und Abkürzungen

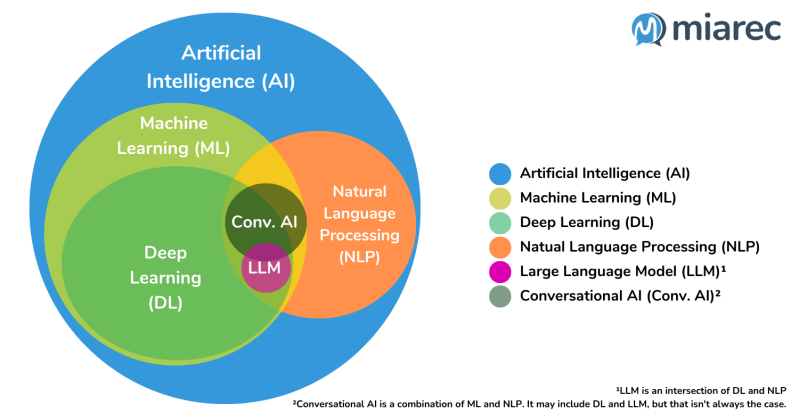

- Artificial Intelligence (AI; dt. KI [künstliche Intelligenz])

AI steht für Artificial Intelligence, also künstliche Intelligenz. Das sind Programme, die Dinge tun, die normalerweise menschliches Denken erfordern – z. B. Probleme lösen oder Bilder erkennen.

- Machine Learning (ML)

Ein Teil von AI ist ML (Machine Learning), also maschinelles Lernen: Computer lernen dabei aus Beispielen, ohne dass man ihnen alles einzeln beibringen muss

- Deep Learning (DL)

DL heißt Deep Learning – das ist eine besondere Form des maschinellen Lernens mit sogenannten neuronalen Netzwerken, die sehr gut z. B. bei Spracherkennung oder Bildern funktionieren.

- Natural Language Processing (NLP)

NLP bedeutet Natural Language Processing – hier geht es darum, dass Computer menschliche Sprache verstehen und verarbeiten können, wie z. B. bei Übersetzungen oder Chatbots

- Large Language Models (LLM)

LLM steht für Large Language Model – das sind sehr große Sprachmodelle, wie z. B. ChatGPT, die viele Texte gelesen haben und deshalb gut auf Fragen antworten oder Texte schreiben können.

Browserbasierte Large Learning Models (LLMs)

📝 Auftrag: Vergleich

Vergleiche 3 verschiedene Large Language Models (z.B. ChatGPT, Claude, Gemini, Grok, Copilot, Perplexity) anhand von klaren Kriterien. Finde heraus: Welches LLM ist wofür am besten geeignet? Wo liegen Stärken und Schwächen?

Ziel: Am Ende weißt du, welches LLM du für welche Aufgabe nutzen solltest – und kannst das begründen!

- Firma

- Jahr

- aktuelle Version

- Stärken

- Schwächen

- Besonderheiten

- Beste Anwendung

- Preismodell

- ...

| Sprachmodell | Firma |

|---|---|

| ChatGPT | OpenAI (USA, 2015) |

| Claude | Anthropic (USA, 2021) |

| Gemini (früher Bard, Google) | Google DeepMind |

| Perplexity | Perplexity AI |

| Grok | xAI (Elon Musk, 2023) |

| Bing | Microsoft (USA, 1975) |

| DeepSeek | deepseek (China, 2023) |

| ... |

GPT (Generated Pretrained Transformer)

| Aspekt | Beschreibung |

|---|---|

| Begriff | Generative Pretrained Transformer – ein KI-Modell, das auf dem Transformer-Architekturprinzip basiert und darauf trainiert ist, Sprache zu erzeugen. |

| Herkunft | Entwickelt von OpenAI, erste Veröffentlichung war GPT-1 im Jahr 2018. |

| Modellgenerationen | - GPT-1 (2018) - GPT-2 (2019) - GPT-3 (2020) - GPT-3.5 (2022) - GPT-4 (2023) |

| Grundprinzip | - Generativ (es erzeugt Inhalte) - Pretrained (es wurde vortrainiert auf großen Datenmengen) - Transformer (neuronale Netzarchitektur) |

| Trainingsdaten | Große Mengen an Text aus dem Internet (z. B. Bücher, Artikel, Webseiten, Foren, Code), aber keine persönlichen Daten einzelner Personen (über 45 Terabyte Text, 45 mit 12 Nullen) |

| Trainingsmethode | 1. Unsupervised Pretraining: Vorhersage des nächsten Tokens im Text 2. Supervised Fine-Tuning 3. Reinforcement Learning (RLHF) |

ChatGPT 4.0

GPT-4.0 (auch als GPT-4 bezeichnet) ist ein großes multimodales Sprachmodell von OpenAI, das im März 2023 veröffentlicht wurde. Es ist ein computerbasiertes Programm, das in der Lage ist, auf natürliche Art und Weise mit Menschen zu kommunizieren und ihnen Antworten auf Fragen oder Aufgaben zu geben. Es nutzt künstliche Intelligenz und maschinelles Lernen, um seine Fähigkeiten zu verbessern und immer präzisere Antworten zu liefern.

Datenbasis

GPT-4 wurde mit einer großen Menge an öffentlich zugänglichen Daten und von OpenAI lizenzierten Daten trainiert, darunter:

-

Bücher, Webseiten, wissenschaftliche Artikel

-

Code-Repositories (z. B. GitHub)

-

Forenbeiträge, Nachrichtenartikel, Anleitungen

-

Keine spezifischen Daten nach September 2021 (in der Ursprungsvariante) – neuere Varianten wie GPT-4o sind bis Mitte 2023 oder später aktualisiert.

Tools

- Bilderstellung

- Internetsuche

- Programmierung von Code

- Texterfassung

- DeepResearch

Stärken und Vorteile

- Eingabesprache Englisch: Wurde umfangreich in Englisch trainiert, andere Sprachen verfügen über weniger Training.

-

Hohe Sprachkompetenz: Sehr präzise Grammatik, Stilistik, Argumentation

-

Besseres logisches Denken: Deutlich besser als GPT-3.5 bei Mathe, Logik, Programmierung

-

Multilinguale Fähigkeiten: Exzellente Leistung in vielen Sprachen (z. B. Deutsch, Französisch, Spanisch)

-

Verständnis komplexer Aufgabenstellungen: GPT-4 kann längere Texte analysieren und strukturierte Aufgaben verarbeiten

-

Multimodalität: In der GPT-4-Vision-Variante auch Bildverstehen (Diagramme, Fotos etc.)

Schwächen und Nachteile

- Halluzinationen: Gibt manchmal plausible, aber falsche Informationen

- Mathematische Genauigkeit: Rechenfehler möglich, besonders bei komplexeren Aufgaben

- Erklärbarkeit: Die Entscheidungsprozesse sind nicht transparent (Blackbox)

- Aktualität: Kein Echtzeit-Wissen, Trainingsdaten sind statisch

- Vorteile: Kann gesellschaftliche Vorurteile aus Trainingsdaten widerspiegeln

- Langfristiger Kontext: Hat zwar ein längeres Gedächtnis (Token), aber kein dauerhaftes Gedächtnis

- Quellen und Bezüge: Werden nur auf Nachfrage geliefert und sind manchmal falsch.

ChatGPT 5.1

Überblick über die aktuelle Modellgeneration

1. Einordnung

ChatGPT 5.1 ist die neueste Version der OpenAI-Sprachmodellreihe (Stand 2025). Es kombiniert textuelle, visuelle und teilweise auditorische Fähigkeiten in einem einzigen multimodalen System. Gegenüber GPT-4.0 wurde die Architektur optimiert, der Kontext stark erweitert und das Tool-Ökosystem verbessert.

2. Datenbasis

GPT-5.1 wurde – wie alle OpenAI-Modelle – auf einer Mischung aus öffentlich verfügbaren, lizenzierten und von Menschen erstellten Trainingsdaten trainiert.

Typische Datenquellen:

-

Bücher, Webseiten, wissenschaftliche Veröffentlichungen

-

Software-Repos (z. B. GitHub-Code)

-

Bilder, Diagramme, technische Zeichnungen

-

Unterrichtsmaterialien, Foren, Anleitungen

-

Audio-/Video-Abschriften

-

Kuratierte Datensätze zur Modellsicherheit und Problemlösung

Die Trainingsdaten reichen bis 2025 (modellabhängig), ergänzt durch laufende Sicherheits- und Qualitätspipelines. Wie immer besitzt das Modell kein Echtzeitwissen, sondern reflektiert den Stand der verwendeten Daten.

3. Tools und Systemfunktionen

GPT-5.1 integriert eine Reihe von Funktionen, die direkt im Modell verankert sind:

Kern-Tools

-

Bildanalyse (Fotos, Grafiken, Handskizzen, Screenshots)

-

Bildgenerierung (DALL·E-Variante, direkter Modus)

-

Websuche (Live-Recherche)

-

Programmierwerkzeuge (Code-Ausführung, Debugging)

-

Dateigenerierung (PDF, DOCX, XLSX, PPTX, …)

-

Python-Notebook-Umgebung

-

Long Context Engine (deutlich größerer zusammenhängender Kontext als GPT-4.0)

-

Deep Research / Reasoning-Modi

Erweiterungen

-

Besseres Verständnis komplexer Bilder

-

Präzisere Zitierstandards bei Nutzung der Websuche

-

Verbesserte Formatierungs- und Dokument-Workflows

-

Höhere Steuerbarkeit über System-/Style-Anweisungen

4. Stärken und Vorteile

Sprachkompetenz

-

Sehr konsistente Grammatik, Terminologie und Struktur

-

Verbesserte stilistische Kontrolle und Layout-Fähigkeiten

-

Breitere und präzisere Mehrsprachigkeit als GPT-4.0

Logik und Problemlösung

-

Deutlich stärkeres deduktives und multistufiges Denken

-

Bessere Leistung bei Mathematik, formaler Logik und Codierung

-

Reduzierte Fehlerrate bei langen Argumentationsketten

Multimodalität

-

Höhere Bildauflösung beim Verstehen

-

Verbesserte Szenenanalyse (Objekte, Layout, Stilmerkmale)

-

Robuste Verbindung von Text und Bild (z. B. Arbeitsblätter, Grafiken)

Kontext

-

Verarbeitung sehr langer Konversationen oder Dokumente

-

Stabilere Referenzen auf frühere Gesprächsteile

-

Präzisere Umsetzung komplexer Vorgaben (z. B. Arbeitsaufträge, Rubriken)

Bedienung und Workflow

-

Verbesserte Dateiausgaben

-

Bessere Interpretation feingliedriger Instruktionen

-

Hohe Konsistenz über mehrere Arbeitsschritte hinweg

5. Schwächen und Grenzen

-

Halluzinationen weiterhin möglich, wenn auch reduziert

-

Keine echte Aktualität: Websuche nötig für neueste Fakten

-

Begrenzte Exaktheit bei sehr formalen mathematischen Beweisen

-

Blackbox-Charakter bleibt bestehen

-

Bias-Risiken weiterhin vorhanden (abhängig von Trainingsdaten)

-

Werkzeugabhängigkeit: Manche Funktionen (z. B. Websuche, python) müssen explizit aktiviert werden

-

Kein dauerhaftes Gedächtnis: Langkontext ist groß, aber nicht persistent

6. Vergleich zu GPT-4.0

Verbesserungen

-

Höhere Genauigkeit, weniger Fehlannahmen

-

Stärkeres "Chain-of-Thought"-Reasoning

-

Besseres Bildverständnis

-

Längere Eingabekontexte

-

Schnellere und kosteneffizientere Verarbeitung

-

Viel stabilere Interpretation komplexer Nutzer-Instruktionen

Konstant geblieben

-

Generatives Sprachmodell ohne Echtzeitbewusstsein

-

Möglichkeit fehlerhafter oder erfundener Informationen

-

Abhängigkeit von Tools für aktuelle Daten und exakte Berechnungen

Quellen:

Erstelle deine eigene Website mit Webador